Data Warehouse: Unterschied zwischen den Versionen

Aus ControllingWiki

Achtung. Sie nutzen eine nicht mehr unterstützte Version des Internet Explorer. Es kann zu Darstellungsfehlern kommen. Bitte ziehen Sie einen Wechsel zu einer neueren Version des Internet Explorer in Erwägung oder wechseln Sie zu einer freien Alternative wie Firefox.| [unmarkierte Version] | [unmarkierte Version] |

Thomka (Diskussion | Beiträge) |

Thomka (Diskussion | Beiträge) |

||

| Zeile 152: | Zeile 152: | ||

Cornelia Putzhammer | Cornelia Putzhammer | ||

| − | [[Kategorie | + | [[Kategorie:IT / Berichtswesen]] |

Version vom 2. Februar 2012, 20:14 Uhr

Inhaltsverzeichnis

Zusammenfassung

Ein Data Warehouse ist eine integrierte, strukturierte und historische Sammlung aller in einem Unternehmen oder Unternehmensbereich vorhandenen Daten. In diesen Datenpool fließen interne und externe Daten ein, die konsolidiert, verdichtet, analysiert und zur Entscheidungsfindung aufbereitet werden. Hierzu sollen auch die Kenntnisse und Erfahrungen der Mitarbeiter zählen. Der Nutzen besteht vor allem in der Vielfalt der möglichen Auswertungen, bedingt aber auch eine strukturierte und zielorientierte Datenerfassung.

Gründe für den Einsatz eines Data Warehouse

Wissensgebundene Dienstleistungen - also etwa Forschung, Entwicklung, Design, Marketing, Logistik und Support - entscheiden zunehmend über den Erfolg von Unternehmen. Darum ist es von grundlegender Bedeutung, das im Unternehmen vorhandene Wissen zur optimalen Erbringung dieser Dienstleistungen adäquat zu verwalten und den betroffenen Usern rechtzeitig und in brauchbarer Form zur Verfügung zu stellen.

In jedem Unternehmen sammeln sich allerdings tagtäglich Unmengen von Daten an und es wird immer schwieriger, diese Daten gewinnbringend zu nutzen. Hierfür ist es erforderlich, die notwendigen Informationen aus diesem Datenberg herauszufiltern und so eine Grundlage für gesicherte strategische Entscheidungen zu schaffen. Dies gestaltet sich aus zwei Gründen schwierig:

- Einerseits sind die Daten eines Unternehmens meist auf alle Abteilungen verteilt.

- Andererseits liegen die Daten in unterschiedlichen Formaten vor (vom Excel-Sheet über das Word-Dokument bis hin zur E-Mail-Datenbank oder sogar zum Karteikasten im Schrank).

Will man nun aus Daten verwertbare Informationen ziehen, muss man

- die unterschiedlichsten Datenquellen zusammenfassen,

- in für die Datenanalyse geeigneter Form aufbereiten und

- den Anwendern verfügbar machen.

Darin steckt die treibende Kraft, ein Data Warehouse aufzubauen. Die Zahl der Mitarbeiter, die Entscheidungen zu treffen haben, ist gegenüber dem Nutzerkreis der früheren Führungsinformationssysteme in den letzten Jahren wesentlich gewachsen. Die dadurch entstandene Notwendigkeit, Daten auch dezentral bereitzustellen, ist ein weiterer Grund, ein Data Warehouse aufzubauen.

Ein zusätzlicher Grund ist das direkte Ansprechen des Kunden durch die neuen Medien, wie z.B. das Internet. Die Menge an elektronischen Kundenkontakten übersteigt in Qualität und Quantität alles, was bisher an Daten in internen Quellen vorhanden war. Dabei erfordern immer schnellere Märkte entsprechend kurze (Re-)Aktionszeiten. Informiertere und kritischere Kunden erfordern ein flexibleres Angebot, das besser auf deren individuelle Bedürfnisse zugeschnitten ist. Um in diesem Umfeld richtige Entscheidungen treffen zu können, benötigen die Verantwortlichen aussagekräftige Fakten.

Charakteristika eines Data Warehouse

Aufgrund unterschiedlicher Voraussetzungen und Anforderungen ist unter einem Data Warehouse keine umfassende Standard-Software, sondern stets eine unternehmensindividuelle Lösung zu verstehen. Ein Data Warehouse ist im Unterschied zu transaktionsorientierten operationalen Systemen[1]

- subjektorientiert: Daten sind auf Sach- oder Themengebiete ausgerichtet und nicht wie bei operationalen Systemen prozess- oder funktionsorientiert, d.h., die innerbetrieblichen Abläufe und Funktionen sind für die Entwicklung der Datenbasis des Data Warehouse von untergeordnetem Interesse und haben somit auch nur geringen Einfluss auf deren Struktur. Die Unternehmensdaten sind aus verschiedenen Blickwinkeln zu betrachten, d.h., der Entscheidungsträger muss aus den Unternehmensdaten unter unterschiedlichen Dimensionen relevantes Wissen ableiten können. Häufig betrachtete Dimensionen sind die Unternehmens-, die Produkt-, die Regional-, die Kunden- oder die Zeitstruktur sowie betriebswirtschaftliche Kenngrößen (z.B. Umsatz, Deckungsbeiträge usw.).

- vollständig integriert: Für gleiche Tatsachen existieren eindeutige Namenskonventionen, Maßeinheiten usw. Es wird eine unternehmensweite Integration von Daten in einem einheitlich gestalteten System angestrebt, um Datenredundanzen und damit verbundene Inkonsistenzen im Datensystem zu vermeiden.

- nicht flüchtig: Änderungen von Feldinhalten bleiben nachvollziehbar durch Historisierung von Informationen. Der Ablauf des Unternehmens wird durch historisierte Informationen widergespiegelt.

- zeitraum bezogen: Daten sind nach Perioden geordnet, da Anfragen sich meist an Zeitperioden orientieren. Während bei operationalen Systemen die zeitpunktgenaue Betrachtung von Daten im Vordergrund steht, geht es hier um zeitraumbezogene Daten, welche die Entwicklung des Unternehmens über einen bestimmten Zeitraum repräsentieren und zur Erkennung und Untersuchung von Trends herangezogen werden.

- nicht volatil[2]: Die Werte eines Data Warehouse sollen nachträglich nur im Ausnahmefall geändert werden. Aus diesem Grund erfolgen nahezu alle Datenzugriffe nur lesend.

Die inhaltliche Ausrichtung des Data Warehouse lässt sich damit unter Aufgabengesichtspunkten wie folgt zusammenfassen: Ein Data Warehouse hat die Aufgabe, themenorientierte und integrierte (i.S.v. vereinheitlichte) Informationen über lange Zeiträume und mit Zeitbezug zur Unterstützung von Entscheidern aus unterschiedlichen internen und externen Quellen periodisch zu sammeln, nutzungsbezogen aufzubereiten und bedarfsgerecht zur Verfügung zu stellen.[3]

Allgemeine Data-Warehouse-Architektur

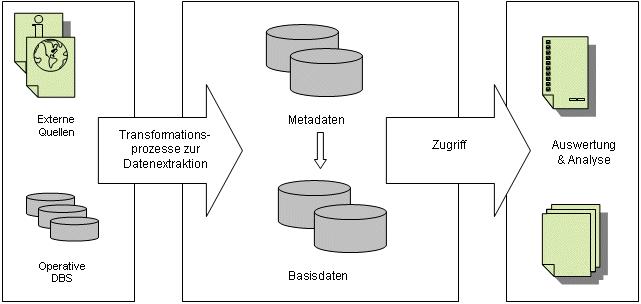

Ein Data Warehouse ist ein "unternehmensweites Konzept, das als logisch zentraler Speicher eine einheitliche und konsistente Datenbasis für die vielfältigen Anwendungen zur Managementunterstützung bietet und losgelöst von den operativen Datenbanken betrieben wird".[4] Es sammelt als zentrale Datenbank in regelmäßigen Intervallen Einträge aus den operativen Systemen und aus externen Quellen, konsolidiert sie, filtert Unwichtiges heraus, ordnet und verdichtet sie, versieht sie mit beschreibenden Zusatzinformationen, so genannten Metadaten, und zeigt mit Hilfe von Analysewerkzeugen Relevantes an.

Data Warehousing ist ein evolutionärer Prozess: Ein Data Warehouse kann man nicht kaufen. Man muss es bauen. Es gibt deshalb kein einfaches Standarddesign für ein Data Warehouse, sondern Größe und Aussehen eines Data Warehouse variieren gemäß der Unternehmensstruktur und den Anforderungen der Benutzer. Konzeption und Erstellung können somit zu einem langwierigen und teuren Prozess auswachsen.

Bei der Implementierung einer Data-Warehouse-Lösung ist zu beachten, dass die für die Unternehmensführung notwendigen Informationen aus den verschiedenen betrieblichen Bereichen (z.B. Produktion, Vertrieb) oder organisationsexternen Quellen wie z.B. Nachrichten- oder Online-Diensten stammen. Entsprechend dem Data-Warehouse-Grundgedanken sind diese Informationen zunächst zusammenzufügen und umzuformen, bevor sie transformiert und schließlich im "Datenlager" gesammelt und aufbereitet werden.

Der Grundaufbau, dem Data-Warehouse-Lösungen mehrheitlich folgen, ist in Abb. 1 dargestellt.

Abb. 1: Allgemeine Data-Warehouse-Architektur

Im Gegensatz zu den auf ihren Fachbereich spezialisierten operativen Datenbanken soll ein Data Warehouse eine globale Sicht ermöglichen. Hierzu muss es so viel Informationen anbieten können wie möglich. Neben den aktuellen Daten beinhaltet es daher auch ältere Werte. Neue Informationen werden periodisch integriert. Hierbei sammelt das Informationslager die Angaben sämtlicher verfügbaren Quellen, zu denen sämtliche Arten von Datenverwaltungssystemen zählen können. Neben den modernen relationalen Datenbankmanagementsystemen gehören hierzu etwa

- hierarchische Datenbanken,

- Dokumente, die irgendwo im Unternehmensnetz verstreut sind,

- Groupware-Systeme wie Lotus Notes,

- Standardanwendungen wie beispielsweise SAP ERP,

- moderne objektorientierte Datenbanken und

- externe Quellen.

Als externe Datenquellen kommen sehr heterogene Datenquellen in Frage, wie z.B. Nachrichtendienste von Wirtschaftsverbänden, Markt-, Meinungs- und Trendforschungsinstitute, externe Datenbanken sowie das Internet. Diese sind deshalb von Interesse, da viele Auswertungen und Analysen, die auf den unternehmensinternen Daten basierend erstellt werden und erst durch den Vergleich mit externen Daten eine für den Entscheidungsträger signifikante Bedeutung erlangen. Durch diese zentrale Speicherung unternehmensexterner Daten im Data Warehouse wird sichergestellt, dass alle Entscheidungsträger mit der gleichen Datenbasis arbeiten. Außerdem wird der Aufwand für die Wissensbeschaffung minimiert.

Komponenten eines Data Warehouse

Ein idealtypisches Data Warehouse umfasst als Komponenten die eigentliche Data-Warehouse-Datenbasis, geeignete Transformationsprogramme zur Datengewinnung aus den unternehmensinternen und -externen Quellen, ein Archivierungs- sowie ein Meta-Datenbanksystem.[5]

- Data-Warehouse-Datenbasis: Die Datenbasis stellt das Data Warehouse i.e.S. dar - es enthält sowohl aktuelle als auch historische Daten in unterschiedlichen Verdichtungsstufen.

- Extraktions-, Transformations- und Ladeprogramme (ETL): Diese sollen bei der Übernahme der Daten ins Data Warehouse für Einheitlichkeit sorgen. Dazu müssen sie Funktionen zur Extraktion von Daten aus unterschiedlichsten operativen Systemen, zur eigentlichen Transformation dieser Daten sowie deren Transport und den Ladevorgang in das Data Warehouse umfassen. Aufgrund der Heterogenität der unterschiedlichen Quellen müssen diese Programme neben den diversen Datenbankidiomen auch die unterschiedlichen Netzwerkprotokolle der Betriebssysteme sowie die Datenstrukturen der einzelnen Anwendungen beherrschen. Die extrahierten Daten werden von den Transformationsprogrammen validiert und gegebenenfalls korrigiert. Integrator-Programme sammeln die Daten aus den verschiedenen Quellen zu einer gemeinsamen Sicht. In einem weiteren Schritt werden sie auf die benötigte Informationsmenge reduziert. Besonders intelligente Programme gehen noch einen Schritt weiter. Wenn sie interessante Werte finden (z.B. Absatzzahlen besonders hoch oder niedrig), gehen sie selbstständig auf die Suche nach den Ursachen und liefern diese gleich mit. Im Idealfall sind diese Transformationsprogramme die einzige Schnittstelle zu den operationalen DV-Systemen und den unternehmensexternen Datenquellen. Die aus den Transformations- und Extraktionsprozessen resultierenden Regeln, Zuordnungen und Definitionen bilden die Grundlage für die Meta-Datenbank.

- Archivierungssystem: Dieses dient vor allem der Datensicherung und -archivierung. Die Datensicherung wird zur Wiederherstellung des Data Warehouse im Falle eines Programm- oder Systemfehlers durchgeführt. Ziel des Archivierungssystems ist es, durch eine effiziente Speicherung und Verarbeitung großer Datenmengen auch für komplexe Ad-hoc-Analysen kurze Antwortzeiten und die schnelle, einfache und vor allem umfassende Bereitstellung von Wissen zu gewährleisten.

- Meta-Datenbanksystem: Metadaten beschreiben die Bedeutung der gespeicherten Daten - sie stellen somit "Daten über Daten" dar. Sie beschreiben aber auch Quellen, Abläufe und Strukturen eines Data Warehouse.[6] Das Meta-Datenbanksystem unterstützt den Endbenutzer bei der Suche nach den für seine Aufgabenlösung relevanten Daten und liefert auch die benötigten Hintergrundinformationen über Datenquellen, Transformationen und Verdichtungen. Darüber hinaus unterstützt es auch die für den Betrieb des Data Warehouse verantwortlichen Mitarbeiter des DV-Bereichs. Für das Data-Warehouse-Management stellt das Meta-Datenbanksystem alle notwendigen Informationen zur Steuerung der Transformationsprozesse bereit, indem die Metadaten sämtliche Informationsflüsse von den Quell- zu den Zieldatenbanken definieren.

Auswertung und Analyse

Als unternehmensweites Instrument soll ein Data Warehouse sämtliche Entscheider flexibel unterstützen. Diese sollen auf möglichst intuitive Weise zu ihren Informationen finden können. Hierbei werden sie von unterschiedlichsten Endanwenderwerkzeugen unterstützt - das Spektrum reicht von einfachen Abfrage-Tools bis zu integrierten Paketen, die ein ganzes Sammelsurium an Analysemethoden anbieten. Altbekannte Produkte, beispielsweise Reporterzeuger oder Statistikpakete, tragen ebenso das Prädikat "Data Warehouse" wie Neuentwicklungen, etwa OLAP-Tools. Die Werkzeuge für Entscheider und Entscheidungsvorbereiter lassen sich grob den folgenden Kategorien zuordnen:

- Report- und Abfragegeneratoren

- Statistik

- Dokumenten-Retrieval

- aktive Informationsfilter

- geographische Informationssysteme (GIS)

- Online Analytic Processing (OLAP)

- Data Mining

- Text Mining

- Führungsinformationssysteme

- Entscheidungsunterstützungssysteme

- abteilungsspezifische Tools

- industriespezifische Tools.

Report- und Abfragewerkzeuge gehören zu den gängigsten Hilfsmitteln, insbesondere für den Zugriff auf relationale Datenbanken. Die weite Verbreitung von Standards für diese Datenmanager (SQL[7], ODBC[8]) hat hierzu sicherlich beigetragen. So kann man - neben den auf Abfrage- und Berichtserzeugung spezialisierten Produkten - die Generatoren der vertrauten Desktop-Datenbank benutzen, um auf beliebige ODBC-Datenquellen zuzugreifen. Dabei muss heutzutage niemand mehr SQL direkt benutzen. Grafische Point-and-Click-Generatoren oder Query-By-Example Werkzeuge, bei denen Anwender aus Beispieldaten Abfragen generieren, erleichtern die Arbeit.

Statistikprogramme ermöglichen unterschiedlichste Auswertungsmethoden - über die Berechnung von arithmetischem Mittel und Standardabweichung bis zu t-Test, Regressions- und Zeitreihenanalyse.

Diese können etwa benutzt werden, um für große Datenmengen Zusammenfassungen zu erstellen oder den Grad der Abhängigkeit zwischen zwei Faktoren zu untersuchen. Dies lässt sich für die verschiedensten Zwecke einsetzen: So sucht etwa der Entwicklungsleiter nach Zusammenhängen zwischen Werkstoffen und bestimmten Fehlertypen, wohingegen der Marketingleiter nach Korrelationen zwischen Werbung und Kaufverhalten fahndet. Neben den althergebrachten Allzweck-Statistikpaketen gibt es inzwischen auch spezialisierte Lösungen. Mit Modellierungswerkzeugen werden Prozesse mathematisch beschrieben, um sie besser einzuschätzen. So müssen etwa internationale Unternehmen Geldbestände oder andere Sicherheiten halten, die ähnlich "flüssig" sind wie Bargeld. Diese Werte können sie grundsätzlich in jedem Land parken, in dem sie vertreten sind. Durch die Simulation, wie sich die Wechselkurse der betreffenden Währungen und das Börsengeschehen auf ihr Depot auswirken, können sie jedoch zusätzliche Gewinne machen beziehungsweise Verluste minimieren. Optimierungs-Tools helfen herauszufinden, welche Eingabewerte eines Prozesses bei vorgegebenen Ressourcenbeschränkungen dessen Ergebnisse maximieren oder minimieren. So lässt sich etwa berechnen, welche Produktmischung bei einem gegebenen Maschinenpark, bestimmten Rohmaterialien und Preisen zu maximalem Gewinn führt.

Document-Retrieval-Systeme speichern zur Bewältigung der Flut der mit Textverarbeitungen, Tabellenkalkulationen etc. erstellten Dateien sämtliche Dokumente eines Unternehmens in einer eigenen, zentralen Datenbank. Dort kann der Anwender etwa nach allen Dateien suchen, die einen bestimmten Schlüsselbegriff enthalten, von einem bestimmten Dateityp sind, in einem vorgegebenen Zeitraum oder von einem bestimmten Mitarbeiter erstellt wurden.

Aktive Informationsfilter durchsuchen selbsttätig die Datenbestände nach Informationen. Dazu spezifiziert der Anwender bestimmte Themen oder Ereignisse, über die er in der Folgezeit informiert werden möchte - etwa dass die Verkaufserträge einer Region unter einem bestimmten Wert liegen. Die Filterprogramme schicken so genannte Agenten auf den Weg. Diese Anwendungen durchkämmen in regelmäßigen Zeitabständen die Datenbestände nach den gesuchten Objekten. Ihre Ergebnisse liefern sie regelmäßig aus; auf Wunsch schlagen sie auch sofort Alarm, z.B. wenn Gefahr droht. Auch Document-Retrieval-Systeme verfügen mitunter über solche aktiven Recherchehelfer.

Geographische Informationssysteme (kurz GIS) stellen Daten in ihrer geographischen Dimension dar. In so genannten thematischen Karten färben diese etwa in Abhängigkeit vom Datenmaterial bestimmte Bereiche unterschiedlich ein. Damit lässt sich etwa der Umsatz eines Produkts nach Postleitzahlgebieten sehr anschaulich aufbereiten. Auch Standortentscheidungen können mit Hilfe dieser Datenkarten vorbereitet werden. So können sie unter Berücksichtung logistischer Informationen wie Straßennetze, Flüsse und Filialen den idealen Platz für ein zentrales Lager ermitteln. Hinterlegt der Benutzer regionale demographische und kaufkraftbezogene Daten, können sie somit neue Filialstandorte vorschlagen.

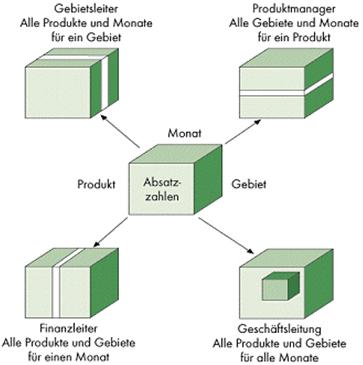

OLAP beschreibt eine Software-Technologie, die betrieblichen Analysten sowie Führungskräften eine mehrdimensionale Sicht auf die Daten des Data Warehouse ermöglicht. Hierfür werden in einem Datenwürfel (oder auf den Achsen eines n-dimensionalen Raumes) verschiedene Dimensionen, wie z.B. Produkt, Region oder Monat, hinterlegt und der Analyst kann die für ihn relevanten Kriterien auswählen und beliebig miteinander kombinieren. So wählt beispielsweise der Gebietsleiter die Dimensionskombination "Umsatz aller Produkte und Monate für ein Gebiet", während der Produktmanager "Umsatz aller Gebiete und Monate für ein Produkt" genauer betrachtet (vgl. Abb. 2).

Abb. 2: Flexibler Datenzugriff

Während OLAP die Antwort auf gezielte Fragen gibt, geht es bei Data Mining um die Entdeckung von verwertbaren Zusammenhängen und Strukturen in den meist sehr umfangreichen Datenbeständen des Data Warehouse.[9] Data Mining ist ein zentraler Prozess im Rahmen des Knowledge Discovery in Databases (KDD), dem Prozess der Wissensgewinnung aus Datenbanken. Kern jedes Data-Mining-Systems sind Analysealgorithmen, wobei sich eine Analyseeinheit immer aus Teilen der Mustererkennung und der Musterbeschreibung zusammensetzt.

- Bei der Mustererkennung werden große Bestände von Datenobjekten herangezogen, um verborgene Zusammenhänge zwischen einzelnen Datenfeldern zu lokalisieren. Es sollen Muster in der Struktur der betrachteten Datenobjekte erarbeitet werden. Muster können alle Beziehungen und Regelmäßigkeiten zwischen Datensätzen und Datenfeldern umfassen.

- Die Hauptaufgabe der Musterbeschreibung ist es, ein erzeugtes Muster oder eine Hypothese über Zusammenhänge und Regelmäßigkeiten heranzuziehen und mit Hilfe von Algorithmen möglichst genau zu beschreiben.

- Neben der Aufdeckung unbekannter Zusammenhänge in untergeordneten Datenbeständen sollen Data-Mining-Tools auch die automatisierte Vorhersage von Trends, Verhalten und Mustern auf Basis hinterlegter Daten vornehmen.

Im Rahmen des Knowledge Discovery in Databases (KDD) beschäftigt sich Text Mining als Ergänzung zum Data Mining mit der Analyse von halb- oder unstrukturierten Textdatenbeständen. Hauptziel ist es, weitgehend automatisiert aus großen Dokumentenkollektionen aussagekräftige Muster sowie Inhalte zu identifizieren und sie dem Anwender komprimiert zu präsentieren. Aufgrund der qualitativen Natur der Daten sind die Problemstellungen algorithmisch komplexer als beim klassischen Data Mining. Das Text-Mining-System bereitet zunächst die Dokumente für die weitere Analyse auf, anschließend sind die Texte zu strukturieren, Auffälligkeiten zu visualisieren und die wichtigsten Fakten herauszufiltern (Extraktion der Kerninformationen). Ein sehr wichtiger Bereich des Text Mining ist die Strukturierung, deren Ziel es ist, einen Überblick über Inhalte großer Dokumentenkollektionen zu liefern, verborgene Gemeinsamkeiten zu identifizieren, eine schnelle Informationsaufnahme zu ermöglichen und ähnliche Dokumente leichter zu finden. Text Mining macht das Lesen von Texten nicht völlig überflüssig. Das System führt den Anwender zu potenziell interessanten Aussagen. Somit liegt der Nutzen darin, dass die in einer umfangreichen Dokumentenmenge verborgenen Fakten in Entscheidungssituationen mit geringerem Aufwand erschlossen werden können.[10]

Da die bislang besprochenen Werkzeuge sowohl in der Einarbeitung als auch in der Anwendung einiges an Zeit in Anspruch nehmen, bieten sich für Führungskräfte, die meist nicht ausreichend Zeit haben, um sich mit der Funktionsweise der komplizierten Werkzeuge vertraut zu machen, Führungsinformationssysteme an. Diese bieten einfache Methoden, Informationen abzufragen oder zu erzeugen. So können über vorgefertigte Analyseschablonen bestimmte Leistungswerte abgefragt werden. Der Preis für die einfache Handhabbarkeit ist allerdings die eingeschränkte Flexibilität dieser Werkzeuge.

Die bisher vorgestellten Anwendungen lassen sich in vielen verschiedenen Bereichen von Firmen einsetzen. Abteilungsspezifische Tools sind dagegen für die Anforderungen bestimmter Unternehmensteile zugeschnitten. Werkzeuge für die finanzielle Analyse sind Spezialisten für Aufgaben, wie etwa Budgetierung, Vorhersage, Konsolidierung und Berichterstattung. Darüber hinaus existieren eigene Lösungen für die Bereiche Marktanalyse und für die Planung von Produktion und Vertrieb. Industriespezifische Tools orientieren sich hingegen an den Bedürfnissen bestimmter Wirtschaftszweige, wie beispielsweise Bank- und Gesundheitswesen, Versicherungen, Einzelhandel, Telefongesellschaften oder Speditionen.

Neben technischen Nutzungspotenzialen liegen die betriebswirtschaftlichen Potenziale eines Data-Warehouse-Systems vor allem in besseren Entscheidungen aufgrund effizienterer Informationsversorgung, in der Erhöhung der Wettbewerbsfähigkeit durch frühzeitige Erkennung von Trends sowie in der Verbesserung von Kundenservice und -zufriedenheit aufgrund des vom Data Warehouse bereitgestellten historischen und aktuellen Wissens über den Kunden.[11]

Fußnoten

[1] Vgl. Mertens, P.; Wieczorrek, H. W. (2000), S. 20.

[2] Volatilität: Grad, mit dem sich Daten im Laufe der normalen Nutzung ändern.

[3] Gabriel, R.; Chamoni, P.; Gluchowski, P. (2000); S. 78.

[4] Gabriel, R.; Chamoni, P.; Gluchowski, P. (2000), S. 76.

[5] Vgl. Mucksch, H.; Behme, W. (1998), S. 40.

[6] Vgl. Mertens, P.; Wieczorrek, H. W. (2000), S. 151.

[7] SQL = Structured Query Language (Standardsprache für den Zugriff auf relationale Datenbanken).

[8] ODBC = Open Database Connectivity (Schnittstellenstandard von Microsoft).

[9] Vgl. Mertens, P.; Wieczorrek, H. W. (2000), S. 212 ff.

[10] Meier, M.; Beckh, M. (2000), S. 165 ff.

[11] Vgl. Mucksch, H.; Behme, W. (1998), S. 86 ff.

Literaturtipps

Gabriel, R.; Chamoni, P.; Gluchowski, P.: Data Warehouse und OLAP - Analyseorientierte Informationssysteme für das Management, in: Zfbf - Schmalenbachs Zeitschrift für betriebswirtschaftliche Forschung, Februar 2000, S. 74-93.

Meier, M.; Beckh, M.: Text Mining, in: Wirtschaftsinformatik, April 2000, S. 165-167.

Mertens, P.; Wieczorrek, H. W.: Data X Strategien. Data Warehouse, Data Mining und operationale Systeme für die Praxis, Berlin/Heidelberg 2000.

Muksch, H.; Behme, W.: Das Data Warehouse-Konzept. Architektur - Datenmodelle - Anwendungen, Wiesbaden 1998.

Ersteinstellende Autorin

Cornelia Putzhammer